15. Januar 2009. Ein Airbus A320 verliert kurz nach dem Start beide Triebwerke durch Vogelschlag. Die Cockpitdaten sagen: zurück zum Flughafen. Der Pilot sagt: keine Chance. Und landet stattdessen – sicher – auf dem Hudson River. „Mir war klar: Wir hatten keine Zeit mehr für Simulationen“, sagte Chesley „Sully“ Sullenberger später. Was ihn rettete, war kein Algorithmus. Es war Erfahrung, Intuition – und eine klare Entscheidung im Angesicht von Unsicherheit. Genau diese Fähigkeit, im richtigen Moment bewusst von der Datenlage abzuweichen, wird heute neu verhandelt – im Zeitalter von Künstlicher Intelligenz.

Fehler: Für KI eine Abweichung, für Menschen ein Risiko

Montagmorgen. Das Dashboard meldet: „Abweichung 4,2 %“. Kein Drama, kein Kontext – nur eine maschinelle Feststellung. Für die KI ist das ein Fehler. Für uns: eine Frage der Deutung. Genau hier beginnt sie – die Kunst des klugen Irrens.

KI versteht Fehler als Differenz zwischen Vorhersage und Ergebnis.

Fehler treiben Lernprozesse an, sind systemimmanent – neutral, emotionslos, korrigierbar. Für Menschen sind Fehler mehr: soziale Risiken, emotionale Stolperfallen, manchmal Karrierekiller. Sie beeinflussen Vertrauen, Status und psychologische Sicherheit.

Diese Differenz wird zur Herausforderung, wenn KI Teil des Entscheidens wird. Denn: Was die Maschine meldet, ist längst mehr als nur Datenpunkte – viele KI-Systeme liefern bereits interpretierte Empfehlungen. Doch genau darin liegt die neue Herausforderung: Die Interpretation wirkt vollständiger, plausibler, oft überzeugender als klassische Datenanalysen – und gerade deshalb wächst die Versuchung, sie als Wahrheit zu behandeln. Doch wo liegt die Verantwortung für die Entscheidung, basierend auf dieser Interpretation?

Wenn Fehlertoleranzen kollidieren

Besonders spannend wird es in Multi-Agenten-Systemen: Hier interagieren KI-Systeme mit unterschiedlich definierten Fehlerschwellen. Was Agent A ignoriert, meldet Agent B als kritisch. Die Folge: Ein technischer „Culture Clash“ — ähnlich wie zwischen Menschen mit unterschiedlichen Vorstellungen davon, was ein gravierender Fehler ist. Nur dass hier die Konflikte emotionslos und algorithmisch „ausgehandelt“ werden: durch stumme Protokolle, Datenabgleiche und Priorisierungsregeln — aber ohne Verständnis für Kontext, Moral oder soziale Auswirkungen.

In Organisationen wird dieses Problem dann spürbar, wenn KI-Agenten nicht interoperabel sind oder wenn KI-Ergebnisse aufeinandertreffen, die aufgrund unterschiedlicher Fehlerdefinitionen unvereinbar scheinen. Plötzlich müssen Menschen vermitteln, wessen Fehlertoleranz zählt — und genau das führt uns zurück zu einer zutiefst menschlichen Führungsaufgabe: mit Unsicherheit umgehen, Kontext erkennen, Verantwortung übernehmen.

Menschen streiten anders. Emotional, mühsam, manchmal destruktiv – aber mit dem Potenzial für gemeinsames Lernen. KI kann nicht reflektieren. Sie priorisiert, verarbeitet, entscheidet – aber sie versteht nicht.

Die Illusion der Objektivität

Je stärker KI wird, desto verlockender ihr Output. Sie suggeriert Sicherheit – auch wenn die Welt komplex und widersprüchlich bleibt.

Was wird durch KI im Führungsalltag mit Blick auf Fehlerkultur leichter?

- Früherkennung: Muster, die zu Fehlern führen könnten, werden immer früher sichtbar (z. B. Produktfeedback, Kündigungswahrscheinlichkeiten, Kundenreaktionen).

- Objektivierbarkeit: Eine größere Datenbasis und sachlich formulierte Interpretationen ermöglichen eine rationalere Gesprächsgrundlage, beispielsweise in Feedback- oder Risikogesprächen.

- Kürzere Lernzyklen: KI ermöglicht es, Fehlerquellen schneller zu identifizieren und daraus gezielter zu lernen.

- Aber genau das macht uns anfällig: Wir delegieren Entscheidungen an Systeme, die nicht wissen, was sie nicht wissen.

Was wird schwerer oder grundlegend anders?

- Verantwortung wird diffuser: Wenn KI-Systeme Entscheidungen immer autonomer vorbereiten oder sogar treffen, wird schwerer greifbar, wer letztlich verantwortlich ist – wer entscheidet, wer haftet?

- Fehler werden entmenschlicht: Ohne soziale Einbettung droht eine Technologisierung des Irrtums – ohne Mitgefühl, ohne persönliche Entwicklung.

- Teamlernen wird anspruchsvoller: Führungskräfte müssen KI-Ergebnisse nicht nur interpretieren, sondern in Teamprozesse einbetten – ohne die Offenheit für eigene Fehler zu unterdrücken.

Was früher Bauchgefühl und Erfahrung war, ist heute Datensignal. Aber: Der Unterschied zwischen Signal und Bedeutung bleibt menschlich. Wir brauchen KI für die Analyse – aber Demut für die Deutung. Denn ohne diese Haltung riskieren wir, in einem System zu führen, das Fehler zwar messen kann, aber nicht begreift. Und je stärker die KI, desto größer unsere Pflicht zur Selbstkorrektur. Denn je präziser das Werkzeug, desto größer die Gefahr, es unkritisch zu übernehmen.

Was Führung jetzt braucht

Wir brauchen eine Fehlerkultur, die integriert statt idealisiert. Und wir brauchen eine Haltung, die Fehler weder heroisiert noch tabuiert – sondern nutzt.

Warum ist das neu? Weil Fehlerkultur zwar lange gefordert wurde, aber selten gelebt. Und weil sich der Druck verändert hat: Seit dem Buchdruck wuchs der Zugang zu Wissen, mit Fernsehen die Reichweite von Botschaften. Mit dem Internet kam Transparenz – und mit KI nun permanente Verfügbarkeit von Antworten. Das Paradoxe dabei: Je mehr Wissen, desto weniger Toleranz für Irrtümer.

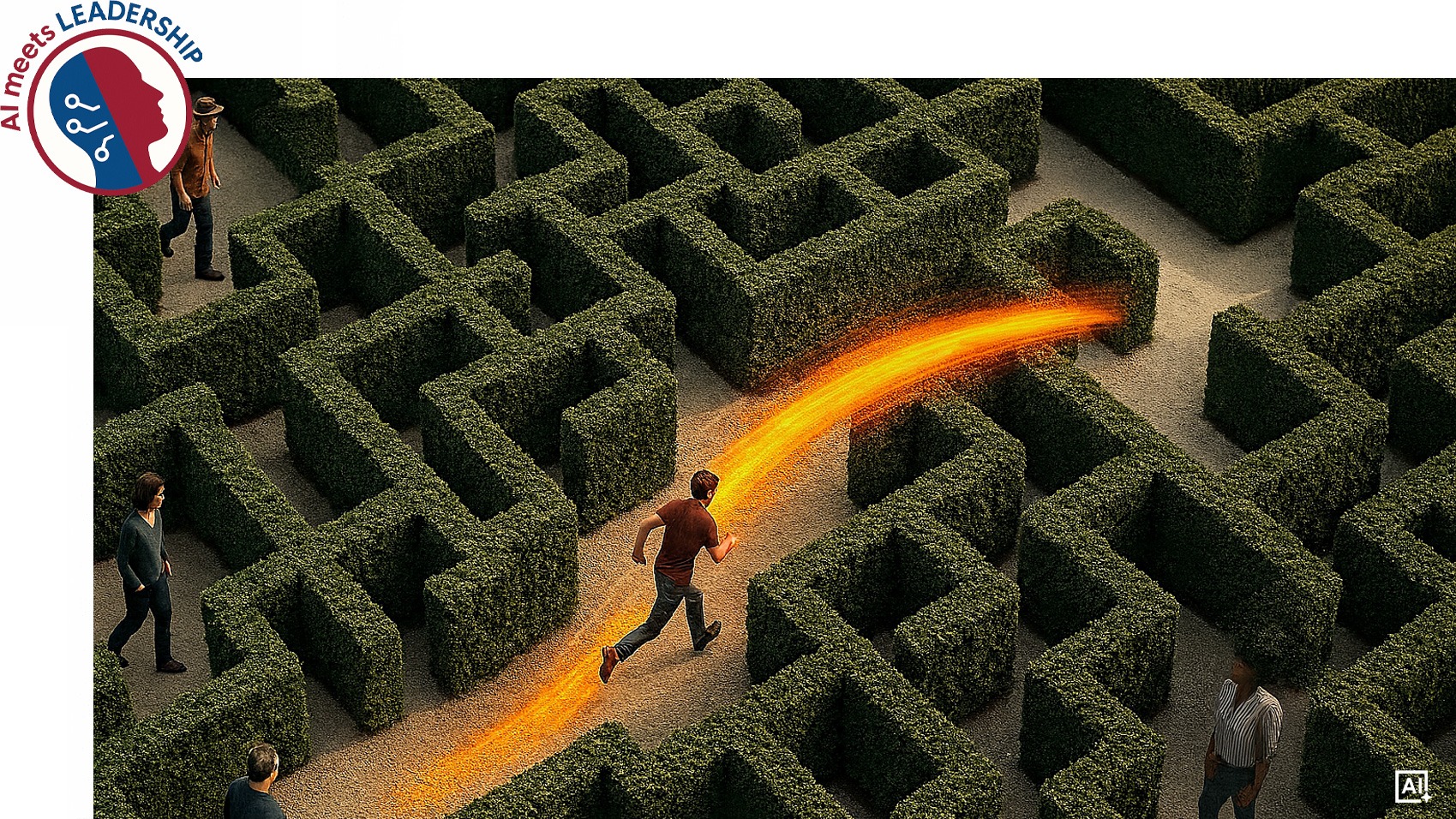

Was früher Unsicherheit war, wird heute als Inkompetenz ausgelegt. Der Raum für Irrtum schrumpft – während unser Navigationssystem komplexer wird. Deshalb braucht es Persönlichkeiten, die führen wollen – nicht perfekt sein. Die Verantwortung annehmen, wo KI nur Muster liefert. Die bereit sind, eigene Annahmen zu hinterfragen.

- Demut statt Kontrollillusion: Nicht alles lässt sich berechnen.

- Verantwortung statt Delegation: KI hilft – aber sie entscheidet nicht.

- Fehler als Impuls für Lernen: Im Team, in der Organisation – und bei uns selbst.

Sullenberger entschied damals gegen die Datenlage – und rettete 155 Leben. Nicht aus Trotz. Sondern weil er verstand: Daten liefern Hinweise, aber keine Wahrheit.

Wer mit Demut führt, hat verstanden: In einer Welt voller Algorithmen und Analysemodelle wird die Fähigkeit zum klugen Irren – also Fehler bewusst zu riskieren, Irrtümer schnell zu erkennen und daraus zu lernen – zur höchsten Form von Intelligenz.